NeurIPS 2024|ProSST: 使用量化结构和解耦注意力的蛋白质语言建模

智药邦

2025-01-10 13:00

文章摘要

本文介绍了NeurIPS 2024上发表的论文“ProSST: Protein Language Modeling with Quantized Structure and Disentangled Attention”,该论文提出了一种新的蛋白质语言模型ProSST,该模型通过结合蛋白质序列和结构信息,利用结构量化模块和序列-结构解耦注意力机制的Transformer架构,显著提升了蛋白质功能预测的性能。研究背景在于现有蛋白质语言模型大多未充分融入蛋白质结构信息,研究目的是通过ProSST模型解决这一问题。实验结果表明,ProSST在多个基准测试中达到了最先进的性能,特别是在零样本突变效应预测和多个监督学习任务中表现卓越。结论指出,ProSST通过有效的结构信息建模和序列-结构解耦注意力机制,显著提升了蛋白质语言模型的性能,尽管存在计算开销较大的问题,未来计划通过技术优化进一步提升模型性能。

本站注明稿件来源为其他媒体的文/图等稿件均为转载稿,本站转载出于非商业性的教育和科研之目的,并不意味着赞同其观点或证实其内容的真实性。如转载稿涉及版权等问题,请作者速来电或来函联系。

智药邦

关于账号进行迁移的说明.

2025-10-20

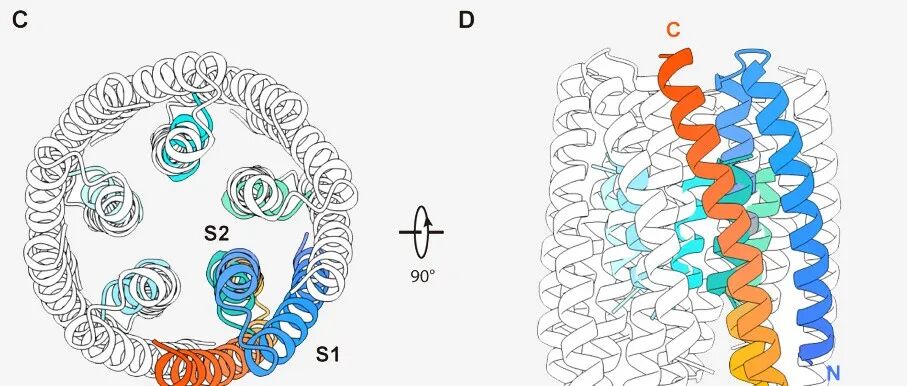

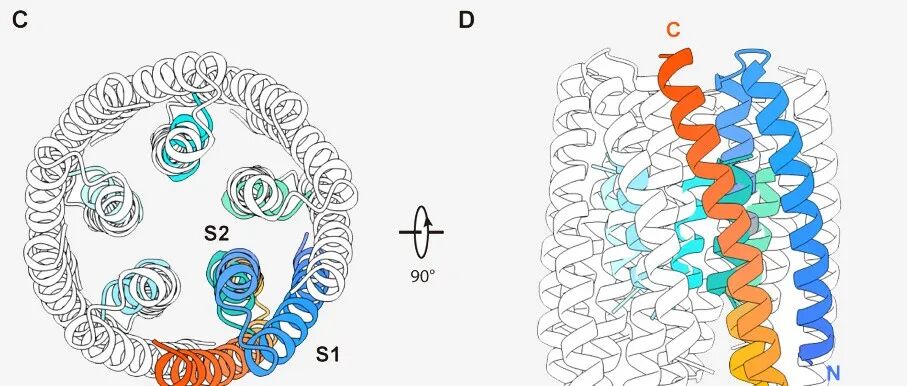

专家点评Cell | 卢培龙团队及其合作者从头设计新型电压门控阴离子通道.

2025-10-20

Cell|西湖大学卢培龙/黄晶等:从头设计新型电压门控阴离子通道.

2025-10-20

Sci Adv丨陈洛南课题组为计算生物学中的干预性因果推断提供新思路.

2025-10-20

Nature|麻省理工学院李巨团队:一种用于多组分电催化剂筛选的多模态机器人平台.

2025-10-19

最新文章

关于账号进行迁移的说明

2025-10-20

Sci Adv丨陈洛南课题组为计算生物学中的干预性因果推断提供新思路

2025-10-20

Cell|西湖大学卢培龙/黄晶等:从头设计新型电压门控阴离子通道

2025-10-20

专家点评Cell | 卢培龙团队及其合作者从头设计新型电压门控阴离子通道

2025-10-20