别再暴力Clip了!千问提出GatedNorm,统一视角揭秘残差流玄学

PaperWeekly

2026-02-03 14:55

文章摘要

背景:Transformer模型训练中,残差流常出现特定维度的激活值异常高(Residual Sink)以及注意力图中首个token权重过高(Attention Sink)的现象,传统工程方法如截断(Clip)试图压制这些异常值以提升数值稳定性或量化效果。研究目的:阿里Qwen团队研究这些异常值的本质,旨在统一解释其成因并探索更稳定的架构改进方案。结论:研究发现异常值是模型在归一化(如RMSNorm)约束下自发演化出的重缩放机制,用于全局调节特征幅度,强制去除会破坏模型性能。因此,团队提出GatedNorm,一种参数高效的门控归一化方法,显式提供缩放能力,消除对不稳定异常值的依赖,从而有效解决低比特量化(如FP4)的精度损失问题,提升模型鲁棒性。

本站注明稿件来源为其他媒体的文/图等稿件均为转载稿,本站转载出于非商业性的教育和科研之目的,并不意味着赞同其观点或证实其内容的真实性。如转载稿涉及版权等问题,请作者速来电或来函联系。

PaperWeekly

代码直接变论文!MSRA同款Agent库开源,读Repo一键生成初稿.

2026-02-03

仅需73美元!Karpathy单卡复现GPT-2,揭秘Muon优化器与架构细节.

2026-02-02

GPT之父Alec Radford新作:从文档级到Token级,重塑大模型数据过滤范式.

2026-01-31

最新文章

代码直接变论文!MSRA同款Agent库开源,读Repo一键生成初稿

2026-02-03

别再暴力Clip了!千问提出GatedNorm,统一视角揭秘残差流玄学

2026-02-03

仅需73美元!Karpathy单卡复现GPT-2,揭秘Muon优化器与架构细节

2026-02-02

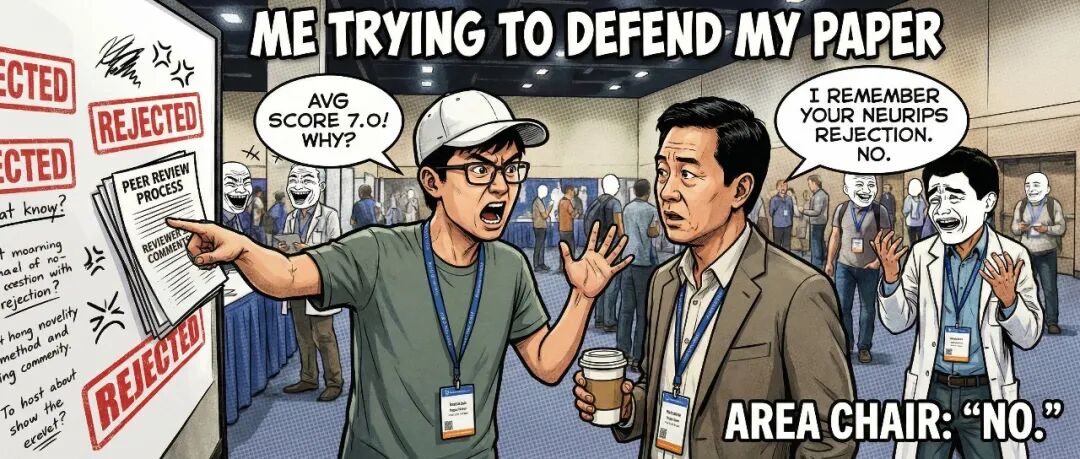

10/8/6/4遭一票否决?ICLR 2026爆争议:AC竟用NeurIPS记忆跨会清算

2026-02-01