聊聊On-PolicyDistillation与那该死的ReverseKL

机器学习算法与自然语言处理

2026-01-27 22:18

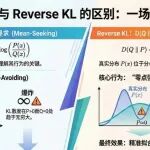

文章摘要

本文探讨了在资源有限条件下,如何通过在线策略蒸馏将大模型能力迁移至小模型。背景上,传统有监督微调存在暴露偏差问题,学生模型难以应对推理阶段的错误状态。研究目的旨在分析在线策略蒸馏中不同分布差异度量方法的作用机制,包括前向KL散度、反向KL散度和JSD散度。结论指出,前向KL过于严厉易导致输出模糊,反向KL虽能因材施教但可能引发模式坍塌,而JSD通过混合分布平衡师生要求,提供稳定训练并避免梯度爆炸,为高效模型蒸馏提供了可行路径。

本站注明稿件来源为其他媒体的文/图等稿件均为转载稿,本站转载出于非商业性的教育和科研之目的,并不意味着赞同其观点或证实其内容的真实性。如转载稿涉及版权等问题,请作者速来电或来函联系。

机器学习算法与自然语言处理

Stable-DiffCoder超越自回归模型!扩散模型在代码生成取得新突破.

2026-02-07

微醺的马斯克聊嗨了:盛赞中国、预言天上的AI.

2026-02-07

比二维码还小!Meta发布TinyLoRA:13个参数媲美全量,RL完胜SFT.

2026-02-07

迈向AI4S2.0,上海AI实验室开源书生万亿科学大模型Intern-S1-Pro.

2026-02-07

万亿市值一夜蒸发!ClaudeCowork血洗全球软件业,老黄急了.

2026-02-06

最新文章

迈向AI4S2.0,上海AI实验室开源书生万亿科学大模型Intern-S1-Pro

2026-02-07

比二维码还小!Meta发布TinyLoRA:13个参数媲美全量,RL完胜SFT

2026-02-07

微醺的马斯克聊嗨了:盛赞中国、预言天上的AI

2026-02-07

Stable-DiffCoder超越自回归模型!扩散模型在代码生成取得新突破

2026-02-07