研究前沿:IBM大型语言模型-混合专家MoE | Nature Computational Science

今日新材料

2025-01-14 14:30

文章摘要

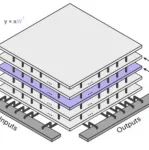

本文探讨了IBM欧洲研究中心在Nature Computational Science上发表的研究,该研究提出了一种结合混合专家模型(MoE)和3D模拟存内计算(AIMC)硬件的方法,以解决大型语言模型(LLMs)在训练和推理过程中面临的高成本和可扩展性挑战。通过利用条件计算机制,研究证明混合专家模型比传统密集模型更适合这种硬件,能够显著降低推理成本并提高能效。研究结果表明,这种结合方法为大型语言模型的高效扩展提供了新的可能性。

本站注明稿件来源为其他媒体的文/图等稿件均为转载稿,本站转载出于非商业性的教育和科研之目的,并不意味着赞同其观点或证实其内容的真实性。如转载稿涉及版权等问题,请作者速来电或来函联系。

推荐文献

Screening apelin analogues and a small molecule agonist as effective cardiovascular therapeutics against reperfusion injury

DOI: 10.1039/D5MD00985E

Pub Date : 2025-12-19

DiffSyn: a generative diffusion approach to materials synthesis planning.

DOI: 10.1038/s43588-025-00949-9

Pub Date : 2026-02-02

Rapidly Expandable Zeolite-Poly(vinyl Alcohol) Sponge for Fast Bleeding Control in Severe Femoral Artery Hemorrhage.

DOI: 10.1021/acsabm.5c01904

Pub Date : 2026-02-06

今日新材料