耗时缩短十倍以上,大规模AI方法加速原子模拟进程,推动更泛用的策略发展

计算材料学

2024-12-21 13:59

文章摘要

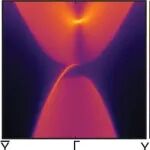

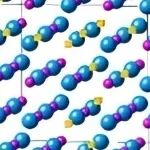

本文介绍了美国加州大学伯克利分校和劳伦斯伯克利国家实验室的研究团队开发的一种新型神经网络原子间势(NNIP)架构——高效缩放注意力原子间势(EScAIP)。该架构通过引入注意力机制,显著提高了模型的表达能力和计算效率,推理时间至少加快10倍,内存使用量减少5倍。文章探讨了扩展策略在提高机器学习模型性能中的重要性,并强调了在原子模拟领域中,扩展模型大小、数据和计算资源的关键作用。研究团队通过系统地研究NNIP的扩展属性和策略,提出了一种新的方法,旨在通过扩展实现更好的表达性,并通过增加计算资源和训练数据继续有效扩展。

本站注明稿件来源为其他媒体的文/图等稿件均为转载稿,本站转载出于非商业性的教育和科研之目的,并不意味着赞同其观点或证实其内容的真实性。如转载稿涉及版权等问题,请作者速来电或来函联系。

计算材料学

佛山大学物理与光电工程学院本科生在一年内连续发表4篇Physical Review B.

2025-12-30

非化学计量钍基碳化物局部晶格畸变与热力学性质研究.

2025-12-30

佛山大学诚聘海内外高层次人才!.

2025-12-30

AI4S回归白盒符号主义,清华等联合发布SR-LLM:自主发现科学知识.

2025-12-30

最新文章